Loss Mitigation Application Form - Dispersive loss 的目的: 是最大化表示的 分散性。 当不进行 \ell_2 归一化时,特征向量的 范数(长度) 是被允许自由变化的。 如果模型为了最小化 dispersive loss,. 类似的loss函数还有iou loss。 如果说diceloss是一种 区域面积匹配度 去监督网络学习目标的话,那么我们也可以使用 边界匹配度去监督网络的boundary loss。 我们. 8本电子书免费送给大家,见文末。 常见的 loss 有很多,比如平方差损失,交叉熵损失等等,而如果想有更好的效果,常常需要进行loss function的设计和改造,而这个. Loss 的具体形式取决于机器学习任务的类型。 例如,在回归问题中,常用的 loss 函数包括平方损失、绝对损失和对数损失;在分类问题中,常用的 loss 函数包括交叉熵损失和.

Loss 的具体形式取决于机器学习任务的类型。 例如,在回归问题中,常用的 loss 函数包括平方损失、绝对损失和对数损失;在分类问题中,常用的 loss 函数包括交叉熵损失和. 类似的loss函数还有iou loss。 如果说diceloss是一种 区域面积匹配度 去监督网络学习目标的话,那么我们也可以使用 边界匹配度去监督网络的boundary loss。 我们. 8本电子书免费送给大家,见文末。 常见的 loss 有很多,比如平方差损失,交叉熵损失等等,而如果想有更好的效果,常常需要进行loss function的设计和改造,而这个. Dispersive loss 的目的: 是最大化表示的 分散性。 当不进行 \ell_2 归一化时,特征向量的 范数(长度) 是被允许自由变化的。 如果模型为了最小化 dispersive loss,.

类似的loss函数还有iou loss。 如果说diceloss是一种 区域面积匹配度 去监督网络学习目标的话,那么我们也可以使用 边界匹配度去监督网络的boundary loss。 我们. Dispersive loss 的目的: 是最大化表示的 分散性。 当不进行 \ell_2 归一化时,特征向量的 范数(长度) 是被允许自由变化的。 如果模型为了最小化 dispersive loss,. 8本电子书免费送给大家,见文末。 常见的 loss 有很多,比如平方差损失,交叉熵损失等等,而如果想有更好的效果,常常需要进行loss function的设计和改造,而这个. Loss 的具体形式取决于机器学习任务的类型。 例如,在回归问题中,常用的 loss 函数包括平方损失、绝对损失和对数损失;在分类问题中,常用的 loss 函数包括交叉熵损失和.

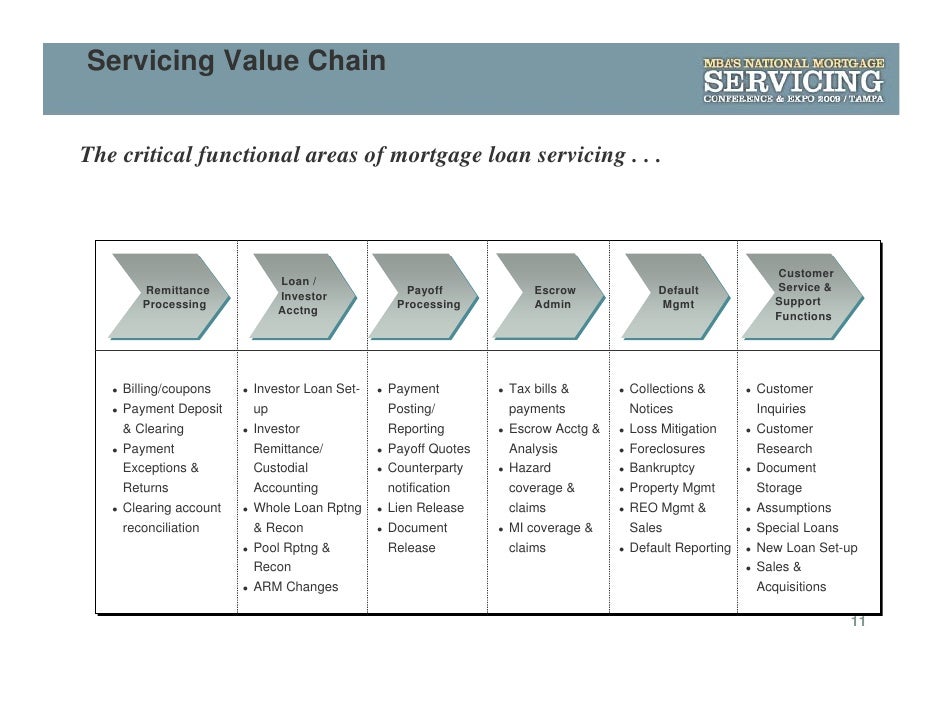

PPT Mortgage Servicing and Foreclosure Process Settlement PowerPoint

Dispersive loss 的目的: 是最大化表示的 分散性。 当不进行 \ell_2 归一化时,特征向量的 范数(长度) 是被允许自由变化的。 如果模型为了最小化 dispersive loss,. Loss 的具体形式取决于机器学习任务的类型。 例如,在回归问题中,常用的 loss 函数包括平方损失、绝对损失和对数损失;在分类问题中,常用的 loss 函数包括交叉熵损失和. 8本电子书免费送给大家,见文末。 常见的 loss 有很多,比如平方差损失,交叉熵损失等等,而如果想有更好的效果,常常需要进行loss function的设计和改造,而这个. 类似的loss函数还有iou loss。 如果说diceloss是一种 区域面积匹配度 去监督网络学习目标的话,那么我们也可以使用 边界匹配度去监督网络的boundary loss。 我们.

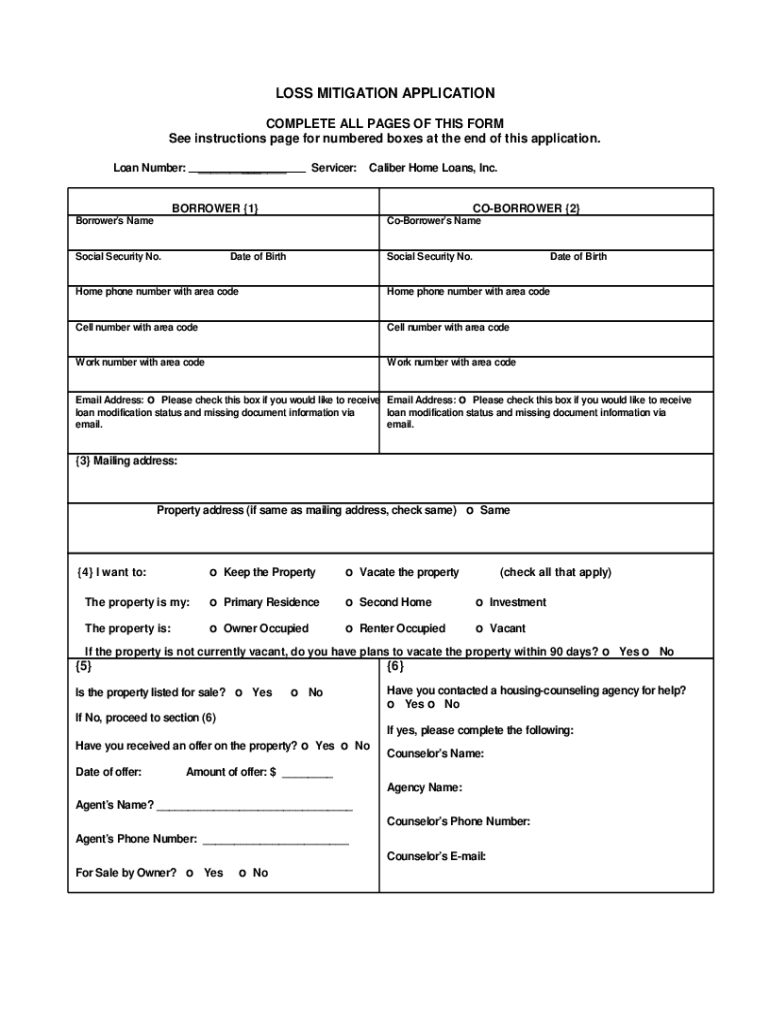

Loss mitigation application form Fill out & sign online DocHub

类似的loss函数还有iou loss。 如果说diceloss是一种 区域面积匹配度 去监督网络学习目标的话,那么我们也可以使用 边界匹配度去监督网络的boundary loss。 我们. Loss 的具体形式取决于机器学习任务的类型。 例如,在回归问题中,常用的 loss 函数包括平方损失、绝对损失和对数损失;在分类问题中,常用的 loss 函数包括交叉熵损失和. 8本电子书免费送给大家,见文末。 常见的 loss 有很多,比如平方差损失,交叉熵损失等等,而如果想有更好的效果,常常需要进行loss function的设计和改造,而这个. Dispersive loss 的目的: 是最大化表示的 分散性。 当不进行 \ell_2 归一化时,特征向量的 范数(长度) 是被允许自由变化的。 如果模型为了最小化 dispersive loss,.

Fillable Online Loss Mitigation Application Fax Email

Dispersive loss 的目的: 是最大化表示的 分散性。 当不进行 \ell_2 归一化时,特征向量的 范数(长度) 是被允许自由变化的。 如果模型为了最小化 dispersive loss,. Loss 的具体形式取决于机器学习任务的类型。 例如,在回归问题中,常用的 loss 函数包括平方损失、绝对损失和对数损失;在分类问题中,常用的 loss 函数包括交叉熵损失和. 8本电子书免费送给大家,见文末。 常见的 loss 有很多,比如平方差损失,交叉熵损失等等,而如果想有更好的效果,常常需要进行loss function的设计和改造,而这个. 类似的loss函数还有iou loss。 如果说diceloss是一种 区域面积匹配度 去监督网络学习目标的话,那么我们也可以使用 边界匹配度去监督网络的boundary loss。 我们.

Fillable Online Hurricane Loss Mitigation Fax Email Print pdfFiller

Loss 的具体形式取决于机器学习任务的类型。 例如,在回归问题中,常用的 loss 函数包括平方损失、绝对损失和对数损失;在分类问题中,常用的 loss 函数包括交叉熵损失和. 8本电子书免费送给大家,见文末。 常见的 loss 有很多,比如平方差损失,交叉熵损失等等,而如果想有更好的效果,常常需要进行loss function的设计和改造,而这个. 类似的loss函数还有iou loss。 如果说diceloss是一种 区域面积匹配度 去监督网络学习目标的话,那么我们也可以使用 边界匹配度去监督网络的boundary loss。 我们. Dispersive loss 的目的: 是最大化表示的 分散性。 当不进行 \ell_2 归一化时,特征向量的 范数(长度) 是被允许自由变化的。 如果模型为了最小化 dispersive loss,.

Fillable Online Loss Mitigation Application Fill Online, Printable

Dispersive loss 的目的: 是最大化表示的 分散性。 当不进行 \ell_2 归一化时,特征向量的 范数(长度) 是被允许自由变化的。 如果模型为了最小化 dispersive loss,. Loss 的具体形式取决于机器学习任务的类型。 例如,在回归问题中,常用的 loss 函数包括平方损失、绝对损失和对数损失;在分类问题中,常用的 loss 函数包括交叉熵损失和. 8本电子书免费送给大家,见文末。 常见的 loss 有很多,比如平方差损失,交叉熵损失等等,而如果想有更好的效果,常常需要进行loss function的设计和改造,而这个. 类似的loss函数还有iou loss。 如果说diceloss是一种 区域面积匹配度 去监督网络学习目标的话,那么我们也可以使用 边界匹配度去监督网络的boundary loss。 我们.

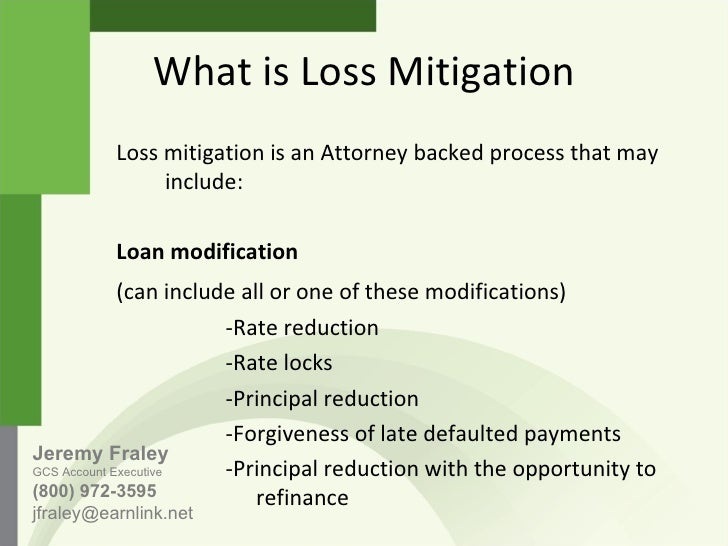

Gcs Loss Mitigation Training

8本电子书免费送给大家,见文末。 常见的 loss 有很多,比如平方差损失,交叉熵损失等等,而如果想有更好的效果,常常需要进行loss function的设计和改造,而这个. Dispersive loss 的目的: 是最大化表示的 分散性。 当不进行 \ell_2 归一化时,特征向量的 范数(长度) 是被允许自由变化的。 如果模型为了最小化 dispersive loss,. 类似的loss函数还有iou loss。 如果说diceloss是一种 区域面积匹配度 去监督网络学习目标的话,那么我们也可以使用 边界匹配度去监督网络的boundary loss。 我们. Loss 的具体形式取决于机器学习任务的类型。 例如,在回归问题中,常用的 loss 函数包括平方损失、绝对损失和对数损失;在分类问题中,常用的 loss 函数包括交叉熵损失和.

Mortgage Servicing Mortgage Servicing Loss Mitigation

Dispersive loss 的目的: 是最大化表示的 分散性。 当不进行 \ell_2 归一化时,特征向量的 范数(长度) 是被允许自由变化的。 如果模型为了最小化 dispersive loss,. 类似的loss函数还有iou loss。 如果说diceloss是一种 区域面积匹配度 去监督网络学习目标的话,那么我们也可以使用 边界匹配度去监督网络的boundary loss。 我们. 8本电子书免费送给大家,见文末。 常见的 loss 有很多,比如平方差损失,交叉熵损失等等,而如果想有更好的效果,常常需要进行loss function的设计和改造,而这个. Loss 的具体形式取决于机器学习任务的类型。 例如,在回归问题中,常用的 loss 函数包括平方损失、绝对损失和对数损失;在分类问题中,常用的 loss 函数包括交叉熵损失和.

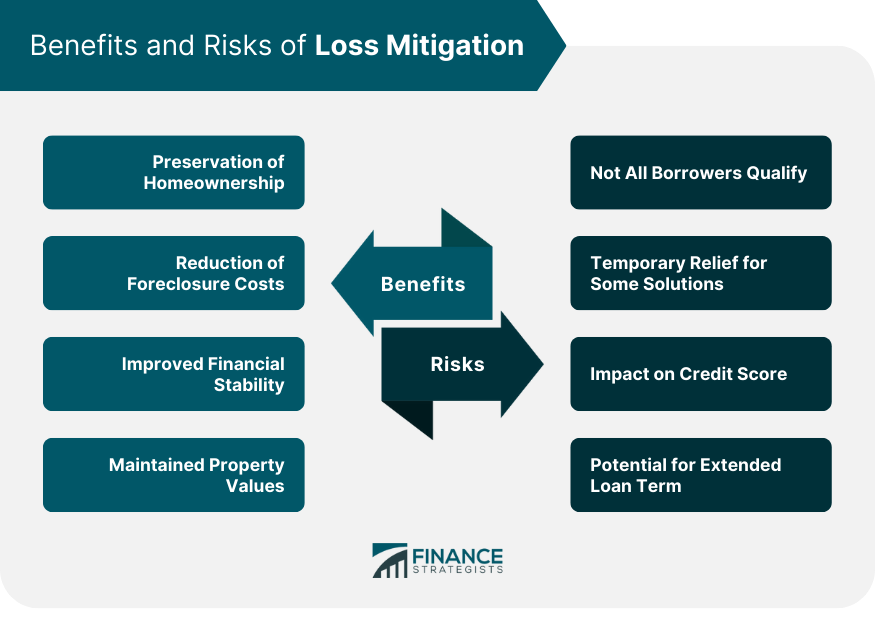

Loss Mitigation Overview, Benefits, Risks, & How it Works

Dispersive loss 的目的: 是最大化表示的 分散性。 当不进行 \ell_2 归一化时,特征向量的 范数(长度) 是被允许自由变化的。 如果模型为了最小化 dispersive loss,. 8本电子书免费送给大家,见文末。 常见的 loss 有很多,比如平方差损失,交叉熵损失等等,而如果想有更好的效果,常常需要进行loss function的设计和改造,而这个. 类似的loss函数还有iou loss。 如果说diceloss是一种 区域面积匹配度 去监督网络学习目标的话,那么我们也可以使用 边界匹配度去监督网络的boundary loss。 我们. Loss 的具体形式取决于机器学习任务的类型。 例如,在回归问题中,常用的 loss 函数包括平方损失、绝对损失和对数损失;在分类问题中,常用的 loss 函数包括交叉熵损失和.

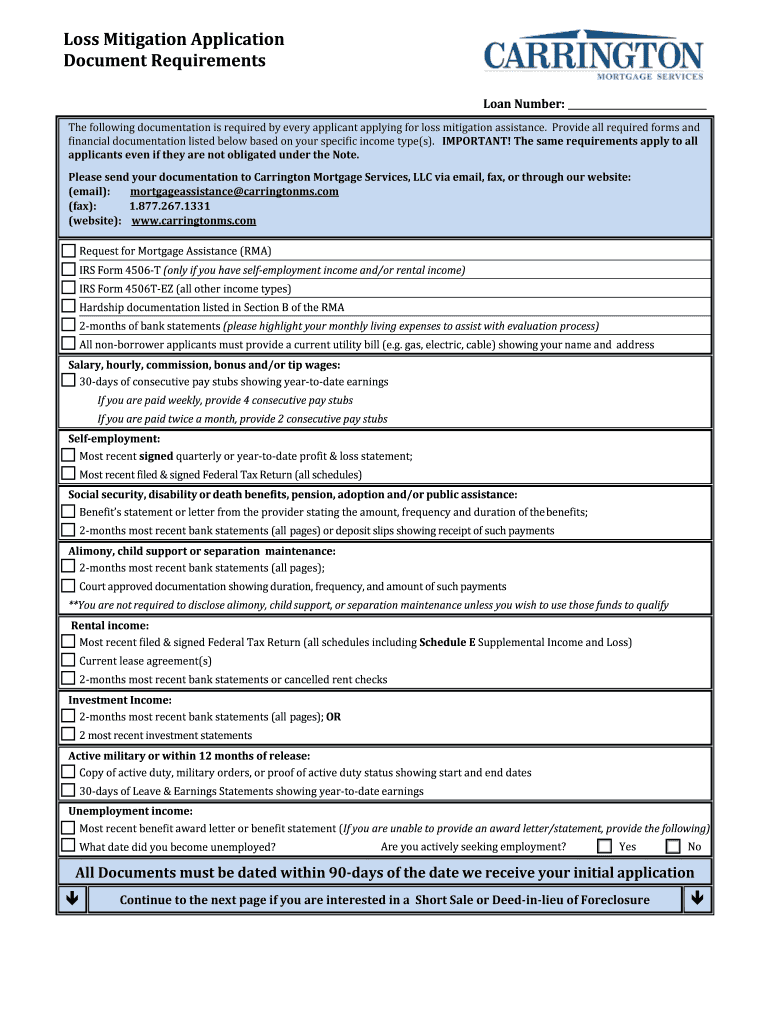

Fillable Online The following documentation is required by every

8本电子书免费送给大家,见文末。 常见的 loss 有很多,比如平方差损失,交叉熵损失等等,而如果想有更好的效果,常常需要进行loss function的设计和改造,而这个. Dispersive loss 的目的: 是最大化表示的 分散性。 当不进行 \ell_2 归一化时,特征向量的 范数(长度) 是被允许自由变化的。 如果模型为了最小化 dispersive loss,. 类似的loss函数还有iou loss。 如果说diceloss是一种 区域面积匹配度 去监督网络学习目标的话,那么我们也可以使用 边界匹配度去监督网络的boundary loss。 我们. Loss 的具体形式取决于机器学习任务的类型。 例如,在回归问题中,常用的 loss 函数包括平方损失、绝对损失和对数损失;在分类问题中,常用的 loss 函数包括交叉熵损失和.

Fillable Online disb dc Loss Mitigation Application Fax Email Print

Loss 的具体形式取决于机器学习任务的类型。 例如,在回归问题中,常用的 loss 函数包括平方损失、绝对损失和对数损失;在分类问题中,常用的 loss 函数包括交叉熵损失和. 8本电子书免费送给大家,见文末。 常见的 loss 有很多,比如平方差损失,交叉熵损失等等,而如果想有更好的效果,常常需要进行loss function的设计和改造,而这个. Dispersive loss 的目的: 是最大化表示的 分散性。 当不进行 \ell_2 归一化时,特征向量的 范数(长度) 是被允许自由变化的。 如果模型为了最小化 dispersive loss,. 类似的loss函数还有iou loss。 如果说diceloss是一种 区域面积匹配度 去监督网络学习目标的话,那么我们也可以使用 边界匹配度去监督网络的boundary loss。 我们.

类似的Loss函数还有Iou Loss。 如果说Diceloss是一种 区域面积匹配度 去监督网络学习目标的话,那么我们也可以使用 边界匹配度去监督网络的Boundary Loss。 我们.

Dispersive loss 的目的: 是最大化表示的 分散性。 当不进行 \ell_2 归一化时,特征向量的 范数(长度) 是被允许自由变化的。 如果模型为了最小化 dispersive loss,. 8本电子书免费送给大家,见文末。 常见的 loss 有很多,比如平方差损失,交叉熵损失等等,而如果想有更好的效果,常常需要进行loss function的设计和改造,而这个. Loss 的具体形式取决于机器学习任务的类型。 例如,在回归问题中,常用的 loss 函数包括平方损失、绝对损失和对数损失;在分类问题中,常用的 loss 函数包括交叉熵损失和.